- お客様事例

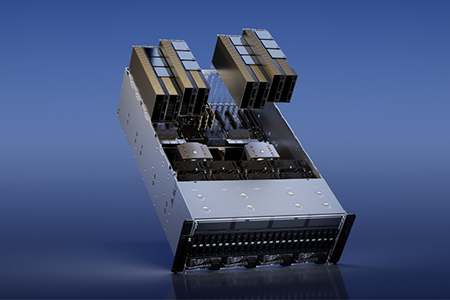

NVIDIA データセンターGPUは、AI推論・生成、ディープラーニング、HPC、シミュレーションなどの大規模並列処理に最適化されたプラットフォームです。ペタFLOPS級の演算性能、大容量HBMメモリ、NVLinkによる高速GPU間通信を備え、開発から運用までを支えるトータルソリューションを提供します。さらに、NVIDIAソフトウェアスタックと管理ツールにより、AIファクトリーの構築を加速します。

アルゴグラフィックスは、最高ランクのNVIDIA Compute Elite パートナーとして、導入から運用までを包括的にサポートします。

NVIDIA H200 Tensor コア GPUは、4.8TB/sで、141GBのHBM3eメモリを提供する初のGPUです。これは、NVIDIA H100 Tensor コア GPUの約2倍のメモリ容量で、メモリ帯域幅は1.4倍です。

NVIDIA H200はLLM推論も高速化されております。Llama2のようなLLMを扱う場合、H100 GPUと比較して推論速度を最大2倍向上します。またシミュレーション、科学研究、人工知能のようなメモリを大量に使用するHPCアプリケーションでは、 H200の高いメモリ帯域幅が、データへのアクセスと操作を効率化し、CPUと比較して110倍の早さで結果を得ることができます。

H200の大容量かつ高速なメモリは、生成AIとLLMを加速し、エネルギー効率を向上させ、総所有コストを低減し、生成AIやハイパフォーマンス・コンピューティング・ワークロードのために大量のデータを処理します。

| 仕様 | NVIDIA H200 Tensor コア GPU |

|---|---|

| GPUメモリ | 141GB |

| GPUメモリ帯領域 | 4.8TB/秒 |

| FP8 Tensor コア パフォーマンス | 4 PetaFLOPS |

| フォーム ファクター | SXM / PCIe |

| サーバー オプション | GPUを4基または8基搭載のNVIDIA HGX H200パートナー製品およびNVIDIA-Certified Systems GPUを8基搭載のNVIDIA MGX H200 NVLパートナー製品およびNVIDIA-Certified Systems |

| デコーダー | 7 NVDEC / 7 JPEG |

| 最大熱設計電力(TDP) | 最大700W(構成可能)/ SXM 最大700W(構成可能)/ PCle |

| NVIDIA AI Enterprise | アドオン / SXM 同梱 / PCle |

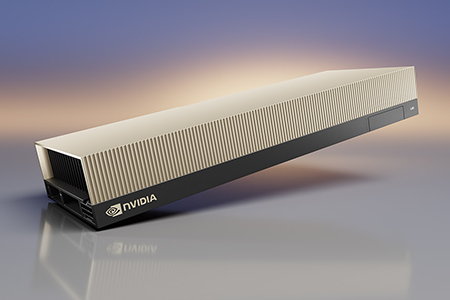

NVIDIA H100 NVLは、1基あたり94GBのメモリを搭載しており、2基のNVIDIA H100 NVLをNVLinkで接続することにより188GBもの大容量メモリと7.8TB/秒のメモリ帯域を実現します。

大量のデータを展開する必要がある生成AIや大規模言語モデル(LLM)の推論に最適化され、前世代のA100と比較して最大12倍高速な推論性能を提供します。

| 仕様 | NVIDIA H100 NVL 94GB |

|---|---|

| GPUメモリ | 94GB HBM3 / ECC対応 |

| GPUメモリ帯領域 | 3.98TB/s |

| CUDAコア数 | 14,592 |

| Tensorコア数 | 456(第4世代) |

| FP64 TFLOPS | 34 |

| FP64 Tensorコア TFLOPS | 67 |

| FP32 TFLOPS | 67 |

| TF32 Tensorコア TFLOPS | 989※ |

| BFLOAT16 Tensorコア TFLOPS | 1979※ |

| FP16 Tensorコア TFLOPS | 1979※ |

| FP8 Tensorコア TFLOPS | 3958※ |

| デコーダー | 7 NVDEC / 7 JPEG |

| 最大熱設計電力(TDP) | 350~400W(構成可能) |

| NVIDIA AI Enterprise | 含む |

※ 新しいスパース性機能を利用した場合の実効値

NVIDIA L40Sは、142基の第3世代RTコア、GPUメモリ48GB GDDR6の搭載により、NVIDIA Ampereアーキテクチャー世代の最大2倍のリアルタイムレイトレーシング性能を実現します。

大量のデータを展開する必要がある生成AIや大規模言語モデル(LLM)の推論に最適化され、前世代のA100と比較して最大1.5倍高速な推論性能を提供します。

| 仕様 | NVIDIA L40S |

|---|---|

| GPUメモリ | 48GB GDDR6 / ECC対応 |

| GPUメモリ帯領域 | 864GB/s |

| CUDAコア数 | 18,176 |

| RTコア数 | 142(第3世代) |

| Tensorコア数 | 568(第4世代) |

| RTコア性能 TFLOPS | 209 |

| FP32 TFLOPS | 91.6 |

| TF32 Tensorコア TFLOPS | 183 / 366※ |

| BFLOAT16 Tensorコア TFLOPS | 362.05 / 733※ |

| FP16 Tensorコア TFLOPS | 362.05 / 733※ |

| FP8 Tensorコア TFLOPS | 733 / 1466※ |

| 最大熱設計電力(TDP) | 350W |

| 仮想GPU(vGPU)ソフトウェア対応 | あり |

※ スパース性を含む